„Beyond the Screen“, so hieß das Motto der diesjährigen FMX, die vom 2. bis 5. Mai im Haus der Wirtschaft in Stuttgart stattfand, und „beyond“ war sie dabei gleich in mehrerer Hinsicht: ein neuer Besucherrekord mit 4000 Teilnehmern, der zunehmend starke Fokus auf Themen wie VR (bzw. jenseits klassisch etablierter Medien), eine wahrnehmbare Annäherung der VFX-Industrie an andere Branchen sowie interdisziplinäre Projekte, verdeutlichten wie in keinem Jahr zuvor die zunehmende Relevanz der FMX als eine international wichtige Austauschplattform für weit mehr als Entertainment. Auch dieses Jahr möchte ich Euch hier wieder einen Erfahrungsbericht darüber geben, was es für angehende Game- und Interaction-Designer zu erleben gab auf der 22sten Konferenz für Animation, Games, Transmedia und – diesmal sicher mehr denn je – Virtual Reality.

Auch wenn aus Sicht eines klassischen Game-Designers das Programm im Vorfeld dieses Jahr nicht sonderlich interessant gewirkt haben könnte (neben dem „Games für Change Europe“ Track schien hier eher wenig vertreten), zeigte sich dieses Jahr vor allem, welche Kompetenzen dieser Branche unerlässlich sein könnten für zukünftige und möglicherweise völlig neue Arbeitsfelder sowie auch, welch enormen Wachstumsmarkt VR und AR zukünftig für den Bereich des Interaktionsdesigns bieten könnten.

1. Tag / Dienstag – Neue Felder für VR und „Games for Change“

Unter diesem Gedanken innovativer Arbeits- und Forschungsbereiche startete bereits der Dienstagmorgen (nach einem Talk über drohnenbasierte Projektionskunst) mit einem äußerst spannenden Vortrag von Dr. Matthias Wölfel von der Universität Furtwangen über eine Reihe von unterschiedlichen Studien und Thesen zum Thema Virtual Reality. Wölfel stelle zunächst die Frage, ob Design für VR die Rekonstruktion der Realität überhaupt brauche, oder ob man bei der Erstellung von VR-Inhalten nicht eher mit bestehenden Herangehensweisen brechen und über das Konzept der „klassischen 3D-Geometrie hinausgehen“ solle. Was Wölfel damit meinte, wurde spätestens in der Vorstellung eines spannenden Experiments deutlich, das sich (ähnlich meiner Masterthesis) mit der Schnittstelle von Haptik und virtueller Realität befasste; dieses M.A.-Projekt von Daniel Hepperle untersuchte hierbei unter Verwendung einer HTC Vive sowie eines eigens erstellten Test-Setups mit Würfeln unterschiedlicher Materialeigenschaften, welche echten Materialien sich konkret zur Simulation virtueller Texturen eignen könnten. Eine weiterführende Forschungsarbeit, deren Erkenntnisse Unternehmen wie „The Void“ mit Sicherheit interessieren könnten.

Eine weitere Testreihe der Forscher bot außerdem die Erkenntnis, dass sich bei der Wahrnehmung von VR-Content drastische Unterschiede zwischen den Geschlechtern im Hinblick auf Farbe, Fokusbereiche und dergleichen zeigen; die Ursache dafür müsse zwar noch erforscht werden, dennoch sei das Wissen um diese Faktoren bereits wichtig für jeden, der sich ernsthaft mit der Erstellung von VR-Erlebnissen befasst.

Wie sehr das tatsächliche Potential von VR und AR in den kommenden Jahren wachsen kann und vermutlich auch wird, wurde in der folgenden Keynote von Autodesk Chef Chris Bradshaw deutlich. Die wesentlichen Essenzen hier lauteten: bis 2025 soll – laut Schätzungen von Goldman Sachs – das jährliche Produktionsvolumen von VR- und AR-Content von derzeit knapp 3 Milliarden (in 2015 war dies noch nicht einmal existent) bis auf über 80 Milliarden Dollar ansteigen (davon 35 Mrd. allein im VR-Software-Sektor). Gründe dafür seien vor allem die schier unzählbaren Anwendungsbereiche von VR/AR (neben Entertainment) wie Design, Qualitätssicherung, Simulationen, Sicherheitschecks, Live-Überprüfungen von Bauprojekten, Wartungen, Schulungen und vieles mehr.

Um dies zu untermauern zeigte Bradshaw ein paar Beispiele, wie eine virtuelle Umgebung, in der Porsche-Ingenieure ein nahezu realistisches Automodell gemeinsam betrachten und live verändern sowie sich gegenseitig digital sehen konnten, während alle Teilnehmer sich jedoch an völlig unterschiedlichen Orten befanden. Zum Abschluss der Keynote sprach Manny Francisco von Dreamworks über neue Methoden mit virtuellen Stages zu arbeiten. Er bezog sich dabei auf die Serien-Produktion für „How to tame your Dragon“ und wie hier mit spielzeugartigen Props, die von Hand bewegt und von einem System getrackt werden, schnell und effizient animierte 3D-Storyboards in einer Virtual-Production-Stage entwickelt werden können.

Generell zeigte sich nicht nur an dem Porsche-Beispiel von Bradshaw, dass auf der FMX dieses Jahr ein erstaunlicher Fokus auf der Automobil-Industrie lag. Viele Firmen wie Jaguar, Audi, Renault und McLaren zeigten Ihre bisherigen Projekte aus diesem Bereich. Dieser Track „Automotive Industries meet Realtime“ begann auch bereits am Dienstagmittag, allerdings schaute ich mir an diesem Nachmittag den „Games for Change Europe“ Track an, da es bezüglich „Automotive“ am Folgetag noch einiges zu sehen geben sollte.

Unter dem Motto „Games for social impact“ präsentierte zuerst Jean-Colas Prunier sein Projekt „Scratchapixel“: eine Website, die vieles rund um das Thema Computer Science und Visual Effects durch einfache Erklärungen intuitiv und schnell vermittelt, selbst wenn der Leser mit dem Thema nicht vertraut ist. Pruniers Projekt ist damit sicherlich nicht nur als gutes Nachschlagewerk für Einsteiger in diesen Bereich, sondern auch als spannendes Modell für Bildungskontexte zu sehen. Laut Prunier fehlen zu letzterem derzeit allerdings noch entsprechende Partner, da vor allem Bildungseinrichtungen sich nur ungern neuen Lernmethoden zu öffnen scheinen.

„Antura and the letters“ war das zweite Game „for Change“, das von Emmanuel Guardiola vorgestellt wurde, und sich der Problematik widmet, dass in Ländern wie Syrien durch militärische Konflikte nahezu die Hälfte aller Kinder im schulfähigen Alter nicht zur Schule gehen können. „Antura“ beschäftigt sich dabei vor allem mit der spielerischen Vermittlung der arabischen Schriftzeichen und ist somit sicherlich ein deutliches Beispiel dafür, wie sich Games als neues Lernmittel verwenden lassen.

Nach einer kurzen Vorstellung der NGO „Videogames without Borders“ mit dem Ziel, Games auch in wirtschaftlich schwächeren Ländern als Lernmittel verfügbar zu machen, stellte Maximilian Krauss von der Hochschule der Medien in Stuttgart sein Modell zur Entwicklung von Serious Games vor. Jedes „Serious Game“ müsse sich bei aller „Seriousness“ auch wie ein Entertainment Game spielen lassen, und dabei die Aspekte „Knowledge, Understanding, Behavior, Ethics“ und „Emotion“ (KUBEE-Modell) gut konzipiert verinnerlichen. Ohne „Engagement“ und Motivation seien solche Spiele nur wenig effektiv, zudem solle man User nicht zum Lernen zwingen und das erlernte Wissen selbst sinnvoll als „Reward“ einbinden. Laut Krauss sei zudem gerade das Erlauben von Fehlern eine essenzielle Lern-Komponente, was im aktuellen Bildungssystem dagegen leider häufig als „zu vermeiden“ gelte. Auf meine abschließende Frage an Krauss, ob der Term „Serious Game“ nicht bereits hinfällig sei (wenn ein gutes SG ohnehin wie ein Entertainment Game spielbar sein muss) und man nicht einfach bei „Game“ als allgemeinem Begriff bleiben solle, entgegnete Krauss, dass „Serious Game“ als Begriff auf Gamer definitiv abschreckend wirken könne, aber man ihn zumindest im Hinblick auf Kooperationspartner und Förderer als wichtigen Marketingbegriff brauche und er somit zumindest in dieser Hinsicht weiter eine Daseinsberechtigung habe.

2. Tag / Mittwoch – AR, Stories & Automotive

Der zweite Tag der Konferenz begann mit zwei Beispielen des Tracks „VR Now“. Das erste Projekt – „Wheelhouse“ von Martin Nerurkar – untersuchte dabei, ob mithilfe eines Rollstuhls ein Alltags-VR-Game so erlebt werden kann, dass der Betrachter mehr Empathie für die alltäglichen Hindernisse eines Rollstuhlfahrers entwickelt. Ein spannender Ansatz – Nerurkar konnte allerdings zu seiner Forschungsfrage noch keine Ergebnisse präsentieren. Mir fiel hier direkt eine Parallele zum 2014 auf der FMX präsentierten Spiel „Outcasted“ auf (welches den Spieler in die Rolle eines Obdachlosen versetzt, bewusst ohne nennenswerte Interaktionsmöglichkeiten mit der Umwelt), das sich zum damaligen Zeitpunkt bereits mit der Möglichkeit von Point-of-View-Spielen auf die Empathie-Entwicklung des Users beschäftigt hatte. Möglicherweise wäre hier eine Kooperation der beiden Parteien sinnvoll?

Das zweite vorgestellte Projekt der Firma „Nau-Hau“ nannte sich „Koshu VR“, konnte aber neben der vorgestellten Möglichkeit, durch clevere Drehungen des Betrachterstandpunktes jede beliebige VR-Umgebung endlos betretbar zu machen, mehr durch seine Ästhetik als sein generelles Konzept überzeugen.

Dagegen konnte Edward Miller von Scape Technologies im Anschluss durch ein faszinierendes Projekt mit dem Thema der Erstellung großangelegter begehbarer AR-Erlebnisse begeistern: durch Verwendung von creative commons Fotorafien (Flickr) und in 360-Grad gefilmten Straßenaufnahmen konnte „Scape“ durch darauf angewandte clevere Deep-Learning Systeme ein nahezu vollständiges 3D-Modell von London erzeugen, das es nun ermöglichen soll, jeden User, der in dieser Umgebung ein entsprechendes AR-Game spielt, unabhängig von GPS und anderen Hilfssystemen so präzise wie möglich in der Szene zu verorten. Damit solle vor allem die korrekte Projektion digitaler Objekte sowie deren realistische Beleuchtung umsetzbar werden. Der treibende Gedanke hinter dem Projekt sei gewesen, dass AR-Welten von Usern in einer Art kollektivem Netzwerk miteinander geteilt und gemeinsam erlebt werden können müssten, um überhaupt langfristig erfolgreichen AR-Content schaffen zu können. Miller erwähnte als Beispiel für erste Anfänge solcher Entwicklungen die „Snap Spectacles“, eine der jüngsten Erfindungen von Snapchat, welche es ermöglicht, animierte 3D-Objekte in Fotografien und Videos live einzubetten; diese Brille sei zwar erst der Anfang, zeige aber bereits, wie solche Technologien durch weniger technisch sondern eher casual fokussiertes Design sich am Markt positionieren könnten, um finanziell in einer breiten Masse erfolgreich zu sein.

In diesem Zusammenhang sollte man laut Miller aktuell auch einmal in Richtung Facebook schauen, da hier derzeit Einiges im Bereich der Bildanalyse entwickelt wird; so wurde auf Facebooks „F8“-Konferenz beispielsweise vorgestellt, wie durch Deep-Learning aus simplen Fotografien Tiefenmaps generierbar werden, anhand derer der Raum als 3D-Modell rekonstruiert und mit diesen Daten derselbe Raum perspektivisch und interaktiv nutzbar gemacht werden kann. Angesichts solcher Möglichkeiten sei es aber nicht nur spannend, wie das (exemplarisch) „nächste Pokémon GO“ aussehen könnte, sondern vor allem auch wichtig, dass angesichts aktuell in Entwicklung befindlicher „Brain Interfaces“ bei aller Innovation Designer und Konsumenten gleichermaßen wachsam bleiben sollten; eine Serie wie „Black Mirror“ sei in diesem Zusammenhang eine wichtige Erinnerung, dass Technologien verantwortungsvoll eingesetzt und immer auch kritisch hinterfragt werden müssen.

„How to Hook an Audience in VR/AR?“ – diese Frage stellen sich sicherlich viele Entwickler und Start-Ups in der VFX-Industrie derzeit, da immer deutlicher wird, wie anders in der Konzeption eines VR-Erlebnisses über Aufmerksamkeit und Freiheit des Users, sich beliebig umzuschauen, nachgedacht werden muss, als dies in klassischen Film-Medien mit fixierten Frames und Einstellungen der Fall ist. Im gleichnamigen Talk stellte Chris O’Reilly von „Nexus Studios“ am Beispiel des interaktiven VR-Kurzfilms „Rain or Shine“ (eine Kooperation mit Google Spotlight Studios) vor, welche Lektionen das Studio an diesem Projekt, das (ähnlich dem 2014 vorgestellten „Windy Day“) primär mit „gaze-based interaction“ arbeitet, lernen konnte. Die Essenzen hier waren: der Betrachter muss durch interessante kleine Trigger-Events dafür belohnt werden, sich umzuschauen; die Welt, in der die zentrale Geschichte stattfindet, muss auch in den Zwischenbereichen mit kleinen emotionalen Elementen angereichert sein, die aber stets wieder dezent zurückführen zum zentralen Handlungsstrang; die passende Konzeption von Sound und Musik für sämtliche Inhalte einer Szene ist essenziell für das Gesamterlebnis. O’Reilly schloss seinen Talk mit einem Zitat von Douglas Adams beziehungsweise der Vermutung, dass man sich in der (möglicherweise gar nicht so) fernen Zukunft fragen wird, warum wir in unserer heutigen Zeit so viele lineare, non-interaktive Unterhaltungsmedien hatten – angesichts der möglichen Konvergenz von Games und Filmen sicherlich ein spannender Gedanke.

Am Nachmittag folgten zunächst zwei Talks, einerseits über „Morphogenic Creations“ von Andy Lomas, der zeigte, wie mittels Deep-Learning (ein dieses Jahr ohnehin recht stark vertretenen Thema auf der FMX) organische Strukturen und deren Wachstum simuliert werden können, was bemerkenswerte Änderungen im Bereich der Kreation natürlicher Elemente für Filme oder Games zukünftig nach sich ziehen könnte, sowie andererseits ein Talk von „Daffy“, der einen kurzen Überblick über seinen Prozess vom Industrie-Veteran hin zur Kreation eigener Inhalte gab.

Es folgte sicher eines der Highlights der FMX 2017 – „Making of Jaguar VR Eperience“ von „Rewind“. Was Daryl Atkins und sein Team hier geleistet hatten, war wirklich außergewöhnlich: ein Multi-User VR-Event für den Launch des Jaguar iPace (die elektrische Variante des fPace) mit 66 internationalen Teilnehmern (VIPs und Journalisten). Für dieses Launch-Event wurden mithilfe der Unity-Engine, 66 HTC Vives sowie einem auf Ubiq basierten, selbst entwickelten Networking-System (zuvor hatte man die Unreal Engine 4 genutzt, diese bot hier anscheinend aber nicht die gewünschte Networking-Performance für derartig viele VR-HMDs) und einer echten Stage für den Präsentator ein digitales VR-Event entwickelt, das in dieser Form sicherlich das erste seiner Art, aber vermutlich nicht das letzte war. Die User bekamen zunächst in VR eine spektakuläre Demonstration des iPace vorgeführt, während der Präsentator in einem ‚echten‘ Studio (welches dynamisch in die digitale Szene eingebunden wurde) einen entsprechend synchronen Vortrag hielt. Die User konnten jedes Detail des neuen iPace aus frei wählbaren Blickwinkeln betrachten sowie anschließend über Voice-Chat Fragen an die Designer stellen, aber auch die anderen Nutzer als abstrakte Avatare während des Erlebnisses sehen. Zum Ende der Präsentation und nach Absetzen des Headsets stand bereits der ‚echte‘ iPace in den jeweiligen, auf zwei Kontinenten verteilten Präsentationsräumen. Ein phänomenales Beispiel für die Herangehensweise an gemeinsam erlebbare VR-Events.

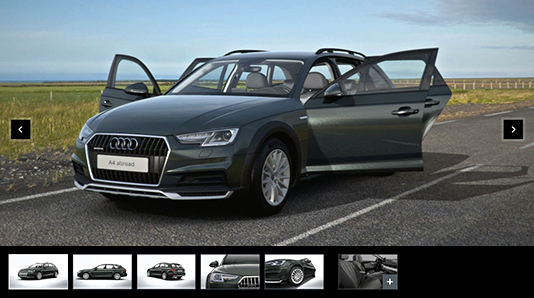

Auch Audi machte mit seinem Vortrag zu „Driving Brand Value Online“ deutlich, dass auch hier auf die Zukunft mit Realtime 3D und VR-Technologie gesetzt wird. So gibt es nun zum einen bei ausgewählten Audi-Händlern die Möglichkeit, sich an einer Vive-Station virtuell in ein Auto zu setzen und dieses im Detail anzuschauen, sowie kleinere Features (Lichter, Öffnen des Kofferraums etc.) auszuprobieren. Neben diesem Marketing-Tool stellte die Agentur „Zero Light“ vor allem den neuen Echtzeit-3D-Konfigurator des Audi A4 vor, welcher bereits als Pilotprojekt in die Audi-Webpräsenz integriert wurde. Alle Renderings laufen in Echtzeit und Cloud-basiert, sodass der User schon nach wenigen Sekunden der Ladezeit ein hochqualitatives 3D-Erlebnis des A4 im Browser zu sehen bekommt, welches komplett konfigurierbar ist. Leider scheint die Applikation trotz bereits realisiertem live-3D nur über Umwege mit Google-Cardboard und dergleichen zu funktionieren, was angesichts der hierfür geringen Software- bzw. Viewport-Anpassung nicht wirklich nachvollziehbar erscheint – in naher Zukunft ist mit einem solchen Feature aber sicherlich zu rechnen.

Der Mittwochabend klang wie so oft mit „Shelley’s Eye Candy“ aus, bei der Shelly Page von Dreamworks Animation wieder einmal ihre jährliche Sammlung inspirierender Kurzfilme vorstellte. Besonders sehenswert waren diesmal: A Love Story, Remote!, Some Thing, Gokurosama, Poles Apart, Asteria, La Parfumerie, sowie das absolut herzerwärmende VR-Filmprojekt „Pearl“.

3. Tag / Donnerstag – Digital Humans, eine Vive-Demo & das Presse-Event

Nach den ersten beiden Tagen der FMX ist man am Donnerstagmorgen nach den vielen Inputs meistens schon etwas ermüdet, aber Hao Li vom Start-Up „PinScreen“ (zuvor bei ILM & Weta Digital) hatte um 10 Uhr morgens bereits eine Präsentation in petto, die vermutlich nicht nur jeden Tech-Interessierten direkt aufgeweckt hätte: unter dem Titel „Digital Human Teleportation“ stellte Li verschiedenste Ansätze aus den Bereichen „Human Digitalization“ und „Avatar-Building“ sowie Methoden zur realistischen virtuellen face-to-face Kommunikation vor. Der gerade einmal 36-jährige Doktor und Computer-Science-Professor zeigte fortgeschrittene Deep-Learning-Systeme als Basis für die (Re-)Konstruktion virtueller Gesichter durch „photorealistic transfer“ auf Basis simpler Fotografien – und die Resultate waren mindestens so erstaunlich wie beängstigend. Einerseits war es verblüffend zu sehen, wie durch derartige Prozesse ein Szenario durchaus denkbar wird, dass zwei Personen, die beide ein VR-Headset tragen, sich dennoch im virtuellen Raum ohne ein solches Headset real betrachten und miteinander interagieren können, da durch clevere DL-Algorithmen das Gesicht in hoher Qualität komplett rekonstruiert werden kann; andererseits implizierten die Erkenntnisse dieses Vortrags auch, dass spätestens nun der Zeitpunkt erreicht ist, ab dem jeder mediale Inhalt in höchster Qualität selbst in Echtzeit fakebar geworden ist oder dies in Kürze sein wird. Eine sicherlich wichtige Komponente in der Diskussion über mediale zukünftige Inhalte, unser Kommunikationsverhalten und die Rolle des Medien-Designers.

Der Track zum Thema „Digital Humans“ wurde im Anschluss von Kiran Bhat von „Loom.ai“ weitergeführt, welcher mit dem Tool „SnapSolver“ anschaulich machte, wie sich aktuelles Face-Tracking vor allem hinsichtlich der 3D-Geometrie deutlich verbessern lässt. Unter Verwendung und Weiterentwicklung solcher Tools sieht Bhat vor allem das Potential immer kleiner werdender Tracking-Tools (wie heutzutage bereits rudimentär mit einfachen Webcams möglich) und die damit einhergehende Zukunft von Face-Tracking durch die Kombination von VFX und Deep-Learning, wie dies auch bereits der Talk zuvor vermuten ließ.

In der Mittagspause testete ich mit einem Journalisten-Kollegen vom VR-Verein Berlin/Brandenburg die von Autodesk ausgestellte Vive-Applikationen mit der neuen in-house Game-Engine „Stingray“. Wir waren beide absolut erstaunt über das flüssige Erlebnis, die haptisch gut konzipierten Interaktionen der Szene, die Darstellungsqualität sowie über die simple Möglichkeit der Portierung sämtlicher 3DS-Max-Daten ohne Umwege (Asset-Exports etc.) in die Engine. Einzig das etwas zu euphorische und über-erklärende Verhalten des Präsentators ließ uns die Szene kaum auf eigene Faust entdecken, was leider nicht für gutes Game-Design sprach, allerdings war dies hier vermutlich auch weniger der Fokus als die Qualität der Engine. Insgesamt jedenfalls ein Erlebnis, das uns nun spätestens von der Vive als sinnvollem VR-Device überzeugen konnte.

Der Donnerstag-Nachmittag hatte mit „Creating the World of Warcraft“ von „Animatrix“ zwar namentlich zunächst etwas zu bieten; als inhaltlich deutlich interessanter zeigte sich allerdings der Talk von Celia Hodent von „Epic Games“ über Neurowissenschaft und deren Erkenntnisse für Game Design. Hodent sprach unter anderem über die Wichtigkeit guter Tutorials, früher Playtests in der Entwicklung, intuitiv gestalteter Icons und „Signs“ als Hinweise für Interaktionsmöglichkeiten, sowie vor allem „Usability“ im Zusammenspiel mit „Engagability“ für das Gelingen eines immersiven Spielerlebnisses (nicht nur für VR). Neben möglichen Unterschieden in der Wahrnehmung jedes einzelnen Users solle man als Game-Entwickler vor allem auch Konzepte wie „change blindness“, „intentional blindness“ und dergleichen beim Entwerfen von Interfaces im Hinterkopf behalten. Vor allem aber sei es wichtig, das Konzept von „affordance“ und „false affordance“ zu verstehen, was im Wesentlichen darauf hinausläuft, dass vor allem in VR jede Interaktion irgendeine Art von Feedback produzieren muss, um dem User jederzeit verständlich zu kommunizieren, was im Moment funktioniert oder auch nicht funktioniert, um Frustration und die Durchbrechung des Erlebnisses zu vermeiden (wie in der Stingray-Demo zuvor bereits als irritierend erlebt).

Das Presse-Event am Abend des dritten Konferenztages war wie jedes Jahr ein entspanntes Get-Together der Industrie, hatte im Vergleich zum letzten Jahr aber leider bezüglich der Talks zu Beginn inhaltlich wenig Neues zu bieten. Zwar waren mit Cheryl Boone Isaacs und Chris Bradshaw namhafte Gäste vor Ort, Isaacs Talk war dabei allerdings eher eine allgemeine Danksagung an die Veranstaltung und die Industrie selbst, und wer am Dienstag Bradshaws Vortrag besucht hatte, bekam hier eins zu eins die gleichen Inhalte präsentiert; allerdings waren seine Voraussagen für die thematisch in den kommenden Jahren zu erwartende drastische Erweiterung der VFX-Industrie im Allgemeinen sowie mit Sicherheit auch die notwendige Vergrößerung der Kapazitäten der FMX wichtig und noch einmal erwähnenswert. Insgesamt bot das Event in seiner Gesamt-Atmosphäre jedenfalls einen angenehmen Abschluss des Tages.

4. Tag / Freitag – Holograms, Mars, Space & Beyond

„A Field Trip to Mars“ war mit Sicherheit eines ein einprägsamsten Projekte, die es auf der FMX dieses Jahr zu sehen gab. Im Gegensatz zur Jaguar VR-Experience hatte dieses „Group-VR“ Projekt aber einen völlig anderen Ansatz, als den Usern VR-Headsets aufzusetzen: ein alter amerikanischer Schulbus wurde zu einem Mars-Expeditionsfahrzeug für Schulklassen umgebaut. Framestore lieferte hier interessante Einblicke, was alles dazu nötig war, ein hochwertig simuliertes Erlebnis einer Bus-Reise über die Oberfläche des Mars zu realisieren: vom Umbau der Fenster hin zu abblendbaren Displays, der Tracking-Technologie für die genaue Positionierung des Busses sowie die Implementierung von Lagesensoren und die gleichzeitige Projektion auf eine Vielzahl von Monitoren machten diese „World’s First Group VR Experience“ nicht nur zu einem technisch ansprechenden Erlebnis, sondern die Entwickler konnten hiermit auch zeigen, dass das Erlebnis deutlich stärkere emotionale Reaktionen hervorrufen konnte, da die Kinder das Erlebnis miteinander direkt teilen konnten, ohne durch Headsets voneinander getrennt zu sein. Eine spannende Zukunftsvision, deren Technologie sicherlich für weitere Bereiche Anwendung finden wird.

Auch der „Human Holograms“ Vortrag on Microsoft wusste mit einer weit entwickelten Capture-Stage für volumetrische Videos zu überraschen. Das System scheint auf seinem aktuellen Stand bereits so präzise zu funktionieren, dass die aufgenommenen Ergebnisse in Ihrer Qualität kaum von klassischem Film zu unterscheiden sind, allerdings mit dem immensen Unterschied, dass es sich bei den Aufnahmen um Szenen handelt, durch die sich eine User-Kamera völlig frei bewegen kann; so ist es Microsoft mittlerweile möglich, fotorealistische Ganzkörper-Performances aufzunehmen und diese anschließend wie in einer Game-Engine frei betrachten oder auch in 360-Grad-Videos (wie man diese schon von Youtube kennt) integrieren zu können – eine faszinierende technische Leistung. Derzeit arbeite man allerdings noch daran, das äußerst aufwändige Capture-Setup möglichst zu verschlanken und im Idealfall portabel zu bekommen, um die Produktionen nicht auf einen festen Studio-Standort beschränken zu müssen. Bereits jetzt könne man aber schon mittels einer so aufgenommenen Video-Library und der App „ActionGram“ in kurzer Zeit „user-generated stories“ und lustige kleine Momente kreieren, die in VR und AR betrachtbar sein sollen.

Wie jedes Jahr gab es gegen Ende der Konferenz eine eher philosophische Aussicht in die Zukunft von VR/AR/MR und der VFX-Industrie im allgemeinen von NYU Professor Ken Perlin und Philippe Quéau von Metaxu. Zuerst hielt Queáu einen kurzen Impulsvortrag darüber, was VR als Konzept in Zukunft alles sein könne (von neuen Arten zu träumen über Schamanismus, Out-of-Body-Experiences bis hin zu neuen Arten von Sozialkontexten) und rief Designer und Entwickler dazu auf, man sollte sich einmal dem Gedankenexperiment stellen, wie VR in 40.000 Jahren aussehen könnte und mit diesem Mindset Dinge entwerfen. Ken Perlin lieferte im Anschluss eine kurze persönliche Geschichte über die „Superpower“ des Geschichten-Ausdenkens, welche nach der Kindheit überwiegend verloren geht und dem daraus resultierenden Willen, diese Art von Magie durch Technologie wieder ins eigene Leben zu holen (wie durch die aktuellen Entwicklungen rund um Games, VFX und AR/VR zu beobachten sei). Ihn treibe dabei vor allem immer wieder die Geschichte von „Harold and the Purple Crayon“ an, in der der Protagonist alles, was er sich nur vorstellen konnte, auch erschaffen konnte. Bis auf diesen Input gab es leider überwiegend Informationen, die Perlin bereits im Vorjahr präsentiert hatte.

In der anschließenden Diskussion der beiden Interviewpartner wurden Dinge diskutiert wie, dass sich VR und AR zunehmend im Bereich der Kommunikation wiederfinden könnten, und dass, was unserer Generation heute technologisch noch „magisch“ erscheint, für unsere Kinder oder deren Kinder im „neuen Zeitalter von Computer Graphics“ bereits völlige Normalität sein könnte. Im Anschluss durften noch Fragen aus dem Publikum diskutiert werden, leider gab es hier einige, die sich über die Stellung Ihrer eigenen langen ‚Frage‘ lieber selbst profilieren wollten, als tatsächlich einen Diskurs anzuregen, weshalb hier kaum Zeit für verschiedene Themen blieb – schade.

Der vorletzte Talk der Konferenz von „Rewind“ über den in Kooperation mit der BBC geschaffenen „Spacewalk“ beschäftigte sich neben dem Vortrag über die technologischen Achievements des Projekts (wie haptische Feedbackmechanismen in der Simulation sowie der Erkenntnis, dass die Immersion eines Space-Erlebnisses sofort durchbrochen zu werden scheint, sobald ein weiterer VR-User Teil des Erlebnisses wird) interessanterweise auch mit der Fragestellung, ob wir bei der Erschaffung von VR-Inhalten überhaupt noch von klassischem Storytelling reden sollten, oder eher den Term „Storyliving“ etablieren sollten. Dabei handele es sich nicht lediglich um eine Begrifflichkeit sondern ein völlig anderes Paradigma, diese Art von Erlebnisinhalten zu begreifen. VR und AR seien nicht direkt Games, aber auch keine Filme – von beiden ließen sich viele Dinge lernen, aber nicht ausschließlich adaptieren – man solle „VR machen“ und nicht etwas anderes; ein Ansatz, der mir dieses Jahr in vielen Talks erstmalig deutlich präsenter erschien und auf weiteren Austausch zwischen den verschiedenen Branchen der VFX-Industrie sowie neue Projektideen hoffen lässt.

Die FMX 2017 endete für uns mit Devon Pennys Vortrag „Effects Tools and Workflows for VR Stories“, welcher über die verschiedenen technischen Herausforderungen berichtete, die sich ihm und seinem Team bei der Erstellung der VR-Kurzfilme „Alumette“, „The Rose and I“ und „Arden’s Wake“ gestellt hatten. Neben Empfehlungen zu Echtzeit-Render-Techniken für stilisierte Wolken und Licht-Brechungen durch Wasser, war Pennys interessanteste Erkenntnis sicherlich, dass wenn ein Designer Inhalte für VR entwickelt und gestaltet, er diese im Idealfall auch direkt in einer VR-Software erstellen sollte, da klassische Modeling-Arbeit am Bildschirm die Wirkung des Endproduktes in VR nur schwer einschätzbar mache. Aus dem gleichen Grund empfahl er auch, Besprechungen über VR-Inhalte mit dem Designteam – sofern möglich – immer in Gruppen-VR-Sessions abzuhalten, da ansonsten Argumente und Kritiken des Directors für das Team nur schwer kommunizierbar und unter Umständen gar nicht nachvollziehbar wären.

Fazit

Selten war die FMX thematisch so einheitlich und doch vielseitiger denn je; auch wenn das Thema „VR/AR“ über den meisten Talks stand, waren doch so viele unterschiedliche Ansätze in diesem neuen Medium erkennbar, von der Adaptierung klassischer Medien in VR bis hin zu völlig neuen Gruppen-VR-Events. Für junge Designer und Programmierer vor allem im Bereich von Game- und Interaction Design könnten die Berufs- und Projektaussichten aktuell besser nicht sein, angesichts des immensen Wachstumspotentials beziehungsweise der immer weiteren thematischen Öffnung dieser Industrie in Richtung einer Vielzahl von Branchen.

Mit diesem großen Wachstumspotential wird sich aber auch die komplett ausgebuchte FMX (im Rückblick wenig überraschend) beschäftigen müssen, als was für eine Konferenz und für welche Zielgruppen sie in Zukunft auftreten möchte, da dieses Jahr bereits mit dem starken inhaltlichen Einfluss der Automobil-Industrie vermutlich – so Chris Bradshaw und andere Analysten – nur einer von vielen möglichen neuen thematischen Zweigen für transmediale und VR-Inhalte hinzugekommen ist. Jedenfalls ist ein Rückgang der Besucherzahlen wohl kaum zu vermuten und wir sind gespannt, was uns nächstes Jahr in Stuttgart „beyond the screen“ erwartet.